Samedi 27 Septembre 2025

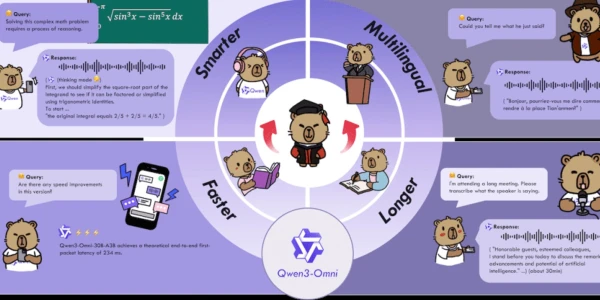

Qwen-3 Omni n'est pas la première tentative d'Alibaba dans le domaine omnimodal : en mars, l'équipe avait déjà dévoilé Qwen-2.5 Omni, qui pouvait également analyser du texte, des images, du son et de la vidéo, et produire des réponses écrites et sonores. Cependant, avec ce modèle de base multilingue open source de bout en bout, elle prétend franchir une étape importante : Qwen-3 Omni serait le premier modèle unifié à maintenir des performances de pointe sur toutes ces modalités, sans perte de précision par rapport à ses homologues monomodaux spécialisés de taille similaire.

Une approche intrinsèquement multimodale

Contrairement aux architectures qui ajoutent progressivement des fonctionnalités autour d'un noyau textuel, Qwen-3 Omni a été conçu comme un modèle multimodal dès le départ : il a été entraîné initialement sur des données textuelles, visuelles et audio-visuelles, ce qui a permis d'éviter la détérioration des performances observée lors de la combinaison ultérieure de modèles spécialisés.

Une architecture optimisée pour la diffusion en continu

Qwen-3 Omni repose sur l'architecture Thinker–Talker, présentée avec Qwen-2.5 Omni, mais considérablement améliorée pour réduire le temps de latence et améliorer la qualité des interactions multimodales. Le module Thinker est responsable du traitement et de la production textuelle, tandis que Talker convertit ces représentations en parole naturelle.

Cinq évolutions techniques caractérisent cette nouvelle génération. Premièrement, les deux modules adoptent une conception Mixture-of-Experts (MoE), capable de gérer des volumes de requêtes plus importants tout en conservant une efficacité de calcul. Deuxièmement, l'encodeur audio Whisper est remplacé par AuT (Audio Transformer), entraîné sur 20 millions d'heures d'audio supervisé. Ce dernier offre une représentation plus robuste des signaux sonores et introduit une attention par blocs qui facilite la mise en cache en temps réel.

Du côté de la synthèse vocale, Qwen-3 Omni adopte une représentation multi-codebook qui augmente la capacité du modèle à restituer des voix diversifiées, des indices paralinguistiques et des phénomènes acoustiques complexes. Talker passe ainsi du mono-piste au multi-piste, chaque couche de codebook étant prédite grâce aux modules de prédiction multi-tokens (MTP). Le rendu sonore, confié au CNN Code2Wav, abandonne une architecture de type DiT pour un réseau convolutionnel allégé, mieux adapté au streaming et à une faible latence. Enfin, la réduction des taux de codage audio en entrée et en sortie à 12,5 Hz permet une synthèse immédiate frame par frame, contribuant à une réactivité de l'ordre de quelques centaines de millisecondes seulement (environ 211 pour l'audio seul et 507 pour les scénarios audio–vidéo).

Qwen-3 Omni prend en charge l'interaction textuelle dans 119 langues, la compréhension vocale dans 19, et la génération de parole dans 10. Grâce à une séparation claire entre les modules Thinker et Talker, le modèle peut être personnalisé via des prompts système distincts, permettant d'ajuster le style de réponse textuelle autant que le ton et le rythme de la voix générée.

Cette architecture facilite également l'intégration avec des outils externes, notamment via des appels de fonctions (Function Calls). Ces appels permettent à des modules tiers comme des bases de données, des agents logiciels ou des filtres de sécurité, d'intervenir directement dans le flux de génération, sans nuire à la cohérence de la réponse. Une approche qui renforce la cohérence des réponses tout en ouvrant la voie à des cas d'usage orientés production...

Performances

Sur 36 benchmarks audio et audio-visuels, Qwen-3 Omni atteint l'état de l'art open source dans 32 cas, et se classe en tête sur 22 d'entre eux, tous modèles confondus. Ces résultats sont d'autant plus remarquables qu'ils surpassent, dans plusieurs scénarios, des modèles propriétaires de référence tels que Gemini-2.5 Pro, Seed-ASR ou GPT-4o-Transcribe.

Plusieurs axes d'amélioration sont déjà identifiés pour les prochaines versions du modèle : la reconnaissance vocale multi-intervenants (ASR), la reconnaissance optique de caractères dans la vidéo (OCR), l'apprentissage proactif audio–vidéo, ainsi qu'un renforcement du support pour les workflows basés sur des agents et les appels de fonctions.