Mardi 09 Septembre 2025

L'adéquation entre efficacité et pérennité représente un défi majeur dans le domaine de l'intelligence artificielle. Tandis que de nombreux projets misent sur des modèles de grande envergure pour des actions simples, ce qui engendre des coûts considérables et une dépense énergétique conséquente, Aramis-2B se positionne dans la dynamique ascendante des Small Language Models (SLM). Élaboré par Jonathan Pacifico, Data Scientist chez Cellenza, ce modèle aux poids ouverts constitue un pas de plus vers la recherche d'un équilibre entre force de déduction, efficience énergétique et intégration au sein d'agents.

Développé par post-entraînement sur BitNet-b1.58-2B-4T de Microsoft Research, Aramis-2B profite de l'utilisation native des poids ternaires (-1, 0, +1) de ce dernier. À l'inverse de la quantification a posteriori, cette approche permet de concevoir des modèles plus légers dès la phase d'apprentissage, avec une consommation d'énergie jusqu'à 20 fois moindre par token sur CPU, sans compromettre la qualité des résultats.

Des aptitudes améliorées pour l'agentique:

Jonathan Pacifico a orienté Aramis-2B vers les applications multi-agents et l'interaction avec l'utilisateur en consolidant trois aspects :

La méthode employée associe un fine-tuning DPO bilingue (FR/EN) et une fusion itérative de modèles. Cette approche permet de stabiliser les performances tout en préservant la diversité des avantages acquis à chaque étape de l'entraînement.

Des résultats concluants:

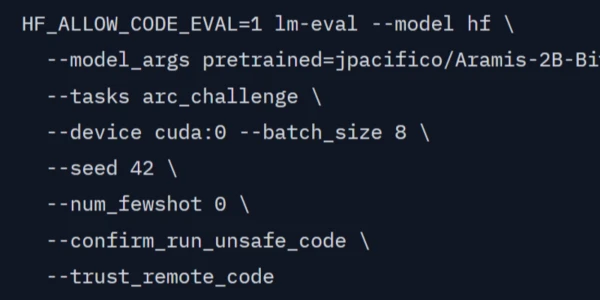

Sur ARC-Challenge, référence en matière de raisonnement scientifique, Aramis-2B obtient un score de 51,62 en zéro-shot, dépassant ainsi le seuil symbolique des 50 points, une première pour un modèle open source de moins de 2,5 milliards de paramètres. Il surpasse non seulement son modèle de base, mais aussi plusieurs concurrents récents de la même catégorie, tels qu’IBM Granite, DeepSeek, Qwen ou MiniCPM. Des améliorations notables sont également constatées sur IFEval, Winogrande, TriviaQA et MMLU.

Le modèle est publié en open weights sur {{HREF}}Hugging Face, sous deux formats :

Jonathan Pacifico invite la communauté à tester Aramis-2B et à lui communiquer ses impressions.

Retrouvez Aramis-2B sur {{HREF}}Hugging Face